¿Qué es robots.txt? ¿Cómo se crea un archivo robots.txt? ¿Por qué es necesario crear un archivo robots.txt? ¿Ayuda la optimización del archivo robots.txt del sitio web a mejorar su clasificación en las búsquedas?

Cubriremos todo esto y mucho más en este artículo en profundidad sobre robots.txt.

¿Alguna vez has querido decirle a los motores de búsqueda que no rastreen un archivo en particular? ¿Ha querido impedir que los motores de búsqueda rastreen una carpeta concreta de su sitio web?

Ahí es donde entra en juego el archivo robots.txt. Se trata de un sencillo archivo de texto que indica a los motores de búsqueda dónde deben rastrear su sitio web y dónde no.

La buena noticia es que no necesita tener ninguna experiencia técnica para liberar el poder de robots.txt.

Robots.txt es un simple archivo de texto que se crea en cuestión de segundos. También es uno de los archivos más fáciles de estropear. Sólo un carácter fuera de lugar, y usted ha echado a perder todo su sitio SEO y evitar que los motores de búsqueda accedan a su sitio.

En trabajar en el SEO de un sitio webel archivo robots.txt desempeña un papel importante. Aunque le permite denegar a los motores de búsqueda el acceso a diferentes archivos y carpetas, no suele ser la forma ideal de optimizar su sitio.

En este artículo, le explicaremos cómo debe utilizar el archivo robots.txt para optimizar su sitio web. También te mostraremos cómo crear uno y compartiremos algunos plugins que nos gustan y que pueden hacer el trabajo duro por ti.

¿Qué es Robots.txt?

Robots.txt es un sencillo archivo de texto que indica a los robots de los motores de búsqueda qué páginas de su sitio deben rastrear. También indica a los robots qué páginas no deben rastrear.

Antes de entrar en profundidad en este artículo, es importante entender cómo funciona un motor de búsqueda.

Los motores de búsqueda tienen tres funciones principales: rastrear, indexar y clasificar.

(Fuente: Moz.com)

Los motores de búsqueda comienzan enviando sus rastreadores web, también denominados arañas o bots, por toda la web. Estos robots son piezas de software inteligente que navegan por toda la web para descubrir nuevos enlaces, páginas y sitios web. Este proceso de exploración de la web se denomina rastreando.

Una vez que los robots descubren su sitio web, sus páginas se organizan en una estructura de datos utilizable. Este proceso se denomina indexación.

Y finalmente, todo se reduce a clasificación. El motor de búsqueda proporciona a los usuarios la información más pertinente en función de sus consultas.

¿Qué aspecto tiene Robots.txt?

Supongamos que un motor de búsqueda está a punto de visitar su sitio. Antes de rastrear el sitio, primero comprobará el archivo robots.txt para obtener instrucciones.

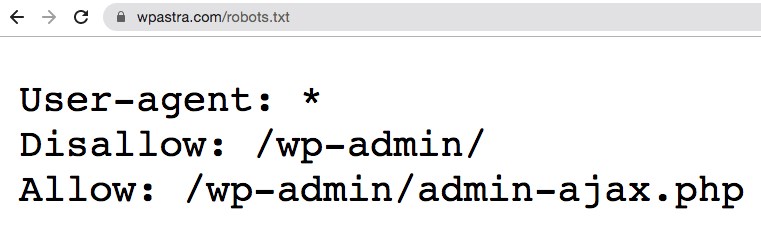

Por ejemplo, digamos que el robot del motor de búsqueda está a punto de rastrear nuestro WPAstra y acceder a nuestro archivo robots.txt, al que se accede desde https://git-staging.wpastra.com/robots.txt.

Ya que estamos en este tema, puede acceder al archivo robots.txt de cualquier sitio web introduciendo "/robots.txt" después del nombre de dominio.

DE ACUERDO. Volviendo al tema.

Este es el formato típico de un archivo robots.txt.

Y antes de que piense que todo es demasiado técnico, la buena noticia es que eso es todo lo que hay en el archivo robots.txt. Bueno, casi.

Desglosemos cada elemento mencionado en el expediente.

La primera es User-agent: *.

El asterisco después de Agente de usuario indica que el archivo se aplica a todos los robots de los motores de búsqueda que visiten el sitio.

Cada motor de búsqueda tiene su propio agente de usuario que rastrea la web. Por ejemplo, Google utiliza Googlebot para indexar el contenido de su sitio web para el motor de búsqueda de Google.

Algunos de los otros usuarios-agentes utilizados por los motores de búsqueda más populares son,

- Google Googlebot

- Noticias de Googlebot: Googlebot-News

- Imágenes de Googlebot: Googlebot-Image

- Vídeo de Googlebot: Googlebot-Video

- Bing: Bingbot

- Yahoo: Slurp Bot

- DuckDuckGo: DuckDuckBot

- Baidu: Baiduspider

- Yandex: YandexBot

- Exalead: ExaBot

- Alexa de Amazon: ia_archiver

Hay cientos de estos usuarios-agentes.

Puede establecer instrucciones personalizadas para cada agente de usuario. Por ejemplo, si desea establecer instrucciones específicas para Googlebot, la primera línea de su archivo robots.txt será,

Agente de usuario: Googlebot

Puede asignar directivas a todos los user-agents utilizando el asterisco (*) junto a User-agent.

Supongamos que desea bloquear todos los robots, excepto Googlebot, para que no rastreen su sitio. Su archivo robots.txt será el siguiente,

User-agent: *

Disallow: /

User-agent: Googlebot

Allow: /La barra (/) después de No permitir indica al bot que no indexe ninguna página del sitio. Y aunque ha asignado una directiva para que se aplique a todos los robots de los motores de búsqueda, también ha permitido explícitamente que Googlebot indexe su sitio web añadiendo 'Permitir: /.’

Del mismo modo, puede añadir directivas para tantos usuarios-agentes como desee.

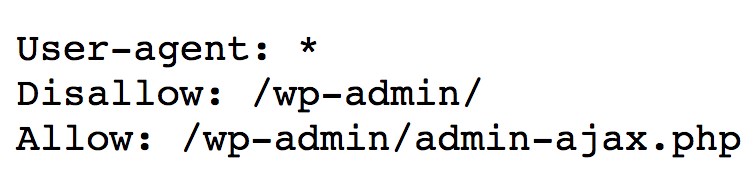

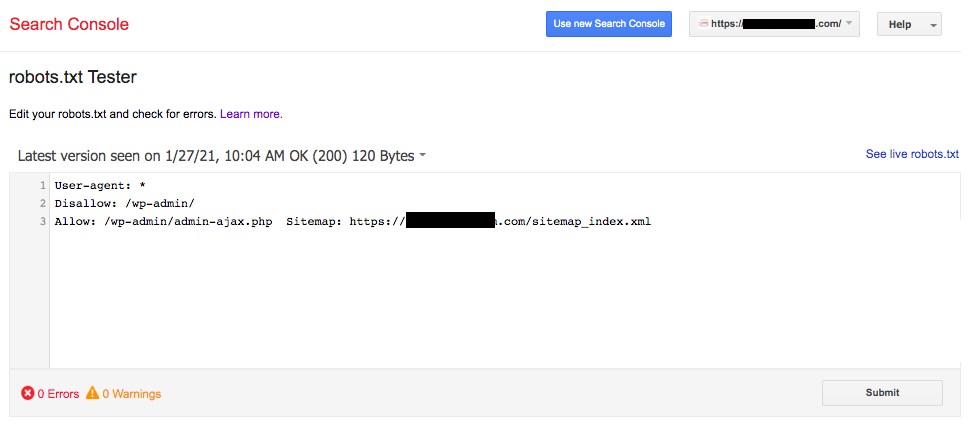

Para recapitular, volvamos a nuestro ejemplo del robots.txt de Astra, es decir

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.phpSe ha configurado la directiva para que todos los robots de los motores de búsqueda no rastreen nada bajo la etiqueta '/wp-admin/', sin embargo, siga las instrucciones de la carpeta 'admin-ajax.phpen la misma carpeta.

Sencillo, ¿verdad?

¿Qué es un presupuesto rastreable?

Añadiendo la barra después de No permitirSi no lo hace, le indica al robot que no visite ninguna página del sitio.

Entonces, la siguiente pregunta obvia sería, ¿por qué alguien querría impedir que los robots rastreen e indexen su sitio? Después de todo, cuando usted está trabajando en el SEO del sitio web, desea que los motores de búsqueda rastreen su sitio para ayudarle a clasificar.

Esta es precisamente la razón por la que debería considerar la optimización de su archivo robots.txt.

¿Tiene idea de cuántas páginas tiene en su sitio web? Desde páginas reales a páginas de prueba, páginas de contenido duplicado, páginas de agradecimiento, entre otras. Muchas, suponemos.

Cuando un robot rastrea su sitio web, rastrea todas y cada una de las páginas. Y si tiene varias páginas, el robot del motor de búsqueda tardará un rato en rastrearlas todas.

(Fuente: Seo Hacker)

¿Sabía que esto puede afectar negativamente a la clasificación de su sitio web?

Y eso se debe a que el bot del motor de búsqueda 'presupuesto de arrastre.'

DE ACUERDO. ¿Qué es un presupuesto rastrero?

Un crawl budget es el número de URL que un robot de búsqueda puede rastrear en una sesión. Cada sitio tendrá asignado un crawl budget específico. Y usted querrá asegurarse de que el presupuesto de rastreo se gasta de la mejor manera posible para su sitio.

Si tiene varias páginas en su sitio web, seguramente querrá que el robot rastree primero sus páginas más valiosas. Por lo tanto, es esencial mencionarlo explícitamente en su archivo robots.txt.

Consulta los recursos disponibles en Google para saber qué significa crawl budget para Googlebot.

¿Cómo crear un archivo Robots.txt en WordPress?

Ahora que ya sabemos lo que es un archivo robots.txt y lo importante que es, vamos a crear uno en WordPress.

Existen dos formas de crear un archivo robots.txt en WordPress. Una utiliza un Plugin de WordPressy la otra es subiendo manualmente el archivo a la carpeta raíz de su sitio web.

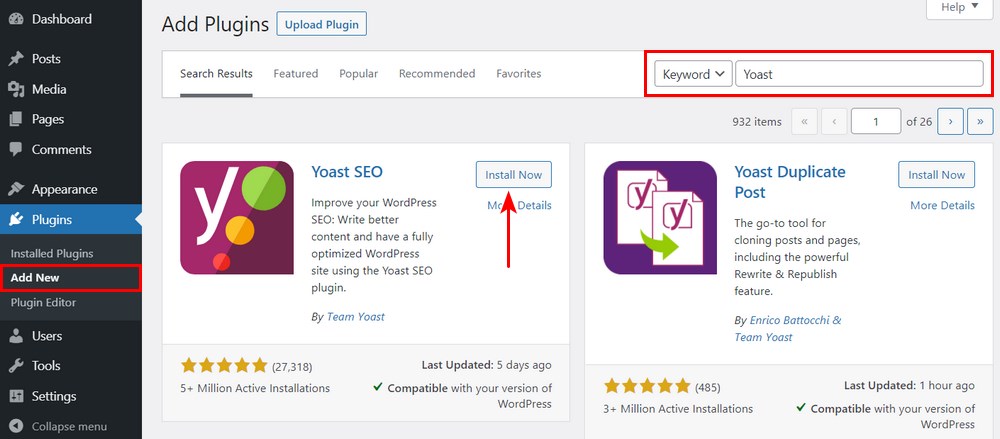

Método 1: Crear un archivo Robots.txt con el plugin Yoast SEO

Para ayudarle a optimizar su Sitio web WordPresspuede utilizar Plugins SEO. La mayoría de estos plugins vienen con su propio generador de archivos robots.txt.

En esta sección, crearemos uno utilizando la función Yoast SEO plugin. Con el plugin, puede crear fácilmente el archivo robots.txt desde el panel de control de WordPress.

Paso 1. Instalar el plugin Instale el plugin

Visite Plugins > Añadir nuevo. A continuación, busque, instale y active el Yoast SEO si aún no lo tiene.

Paso 2. Crear el archivo robots.txt Crear el archivo robots.txt

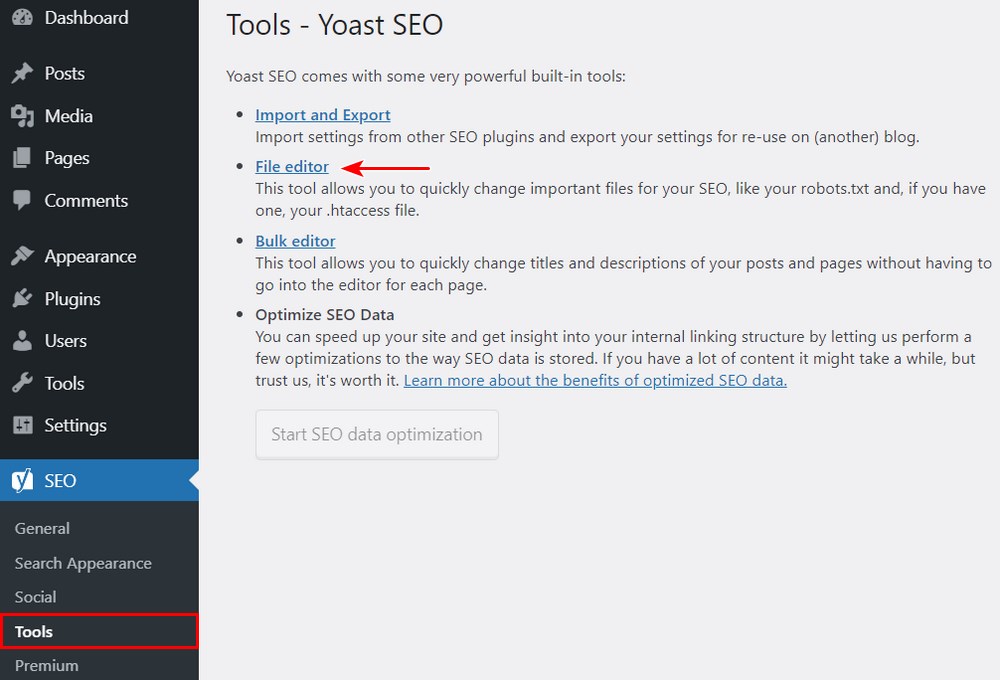

Una vez activado el plugin, vaya a Yoast SEO > Herramientas y haga clic en Editor de archivos.

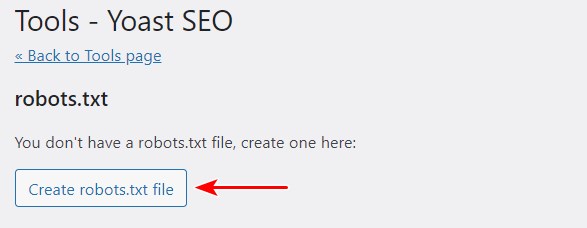

Como es la primera vez que creamos el archivo, haga clic en Crear archivo robots.txt.

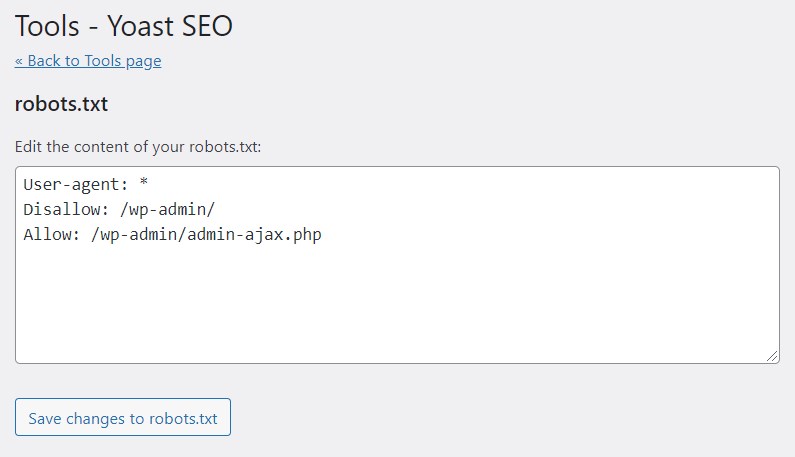

Observará que el archivo se ha creado con algunas directivas predeterminadas.

Por defecto, el generador de archivos robots.txt de Yoast SEO añadirá las siguientes directivas,

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Si lo desea, puede añadir más directivas al robots.txt. Cuando haya terminado, haga clic en Guardar los cambios en robots.txt.

Escriba su nombre de dominio seguido de '/robots.txt.' Si en el navegador aparecen las directivas predeterminadas, como se muestra en la imagen siguiente, habrá creado correctamente su archivo robots.txt.

También le recomendamos que añada la URL del mapa del sitio en su archivo robots.txt.

Por ejemplo, si la URL del mapa del sitio web es https://yourdomain.com/sitemap.xml, considere la posibilidad de incluir la dirección Mapa del sitio: https://yourdomain.com/sitemap.xml en su archivo robots.txt.

Otro ejemplo es si desea crear una directiva para bloquear el bot de rastrear todas las imágenes en su sitio web. Y digamos, que nos gustaría restringir esto sólo al GoogleBot.

En tal caso, nuestro robots.txt será el siguiente,

User-agent: Googlebot

Disallow: /uploads/

User-agent: *

Allow: /uploads/

Y en caso de que te preguntes cómo averiguar el nombre de la carpeta de imágenes, simplemente haz clic con el botón derecho en cualquier imagen de tu sitio web, selecciona abrir en una nueva pestaña y anota la URL en el navegador. Ya está.

Método 2: Crear archivo Robots.txt manualmente usando FTP

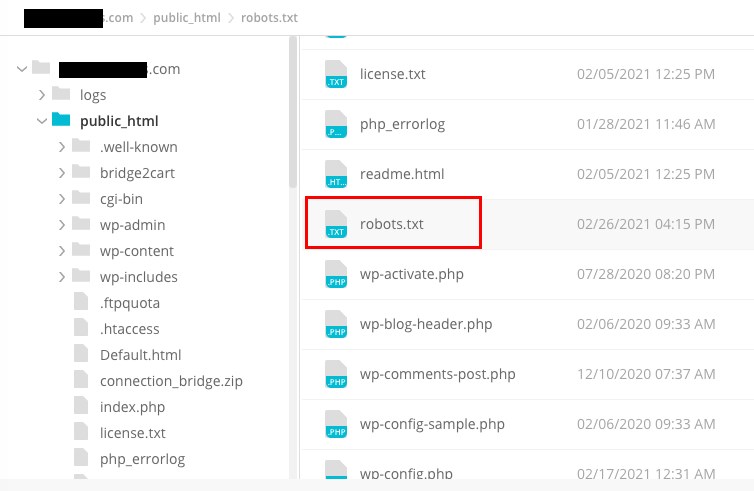

El siguiente método consiste en crear un archivo robots.txt en su ordenador local y subirlo a la carpeta raíz de su sitio web WordPress.

También necesitará acceder a su Alojamiento de WordPress utilizando un cliente FTP, como Filezilla. Las credenciales necesarias para iniciar sesión estarán disponibles en el panel de control de su alojamiento si aún no las tiene.

Recuerde que el archivo robots.txt debe cargarse en la carpeta raíz de su sitio web. Es decir, no debe estar en ningún subdirectorio.

Así, una vez que haya iniciado sesión con su cliente FTP, podrá ver si el archivo robots.txt existe en la carpeta raíz de su sitio web.

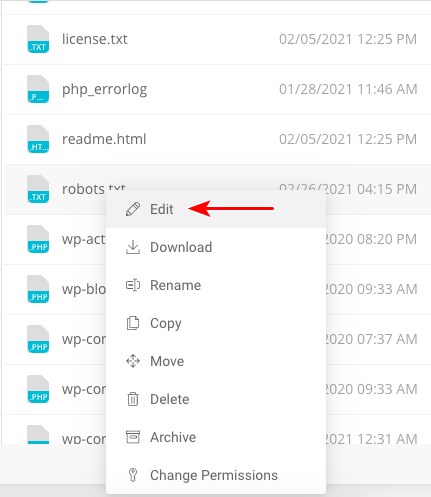

Si el archivo existe, basta con hacer clic con el botón derecho del ratón sobre el archivo y seleccionar la opción de edición.

Realice los cambios y haga clic en Guardar.

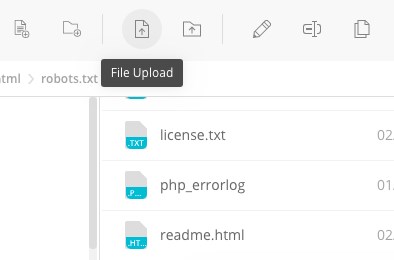

Si el archivo no existe, tendrás que crearlo. Puede crearlo utilizando un archivo editor de texto sencillo como el Bloc de notas y añada las directivas al archivo.

Por ejemplo, incluya las siguientes directivas,

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php... y guarde el archivo como robots.txt.

Ahora, utilizando su cliente FTP, haga clic en 'Carga de archivosy suba el archivo a la carpeta raíz del sitio web.

Para comprobar si su archivo se ha cargado correctamente, introduzca su nombre de dominio seguido de '/robots.txt'.

Y así es como se carga manualmente el archivo robots.txt en el sitio web de WordPress.

Pros y contras de Robots.txt

Ventajas del archivo robots.txt

- Ayuda a optimizar los presupuestos de rastreo de los motores de búsqueda indicándoles que no pierdan tiempo en páginas que no desea indexar. Esto ayuda a garantizar que los motores de búsqueda rastreen las páginas que son más importantes para usted.

- Ayuda a optimizar su servidor web bloqueando los bots que malgastan recursos.

- Ayuda a ocultar páginas de agradecimiento, páginas de aterrizaje, páginas de inicio de sesión, entre otras que no necesitan ser indexadas por los motores de búsqueda.

Contras del archivo robots.txt

- Ahora ya sabe cómo acceder al archivo robots.txt de cualquier sitio web. Es muy sencillo. Basta con introducir el nombre del dominio seguido de '/robots.txt'. Sin embargo, esto también entraña cierto riesgo. El archivo robots.txt puede incluir URLs a algunas de sus páginas internas que no le gustaría que fueran indexadas por los motores de búsqueda.

Por ejemplo, puede haber una página de inicio de sesión que no quiera que se indexe. Sin embargo, mencionarla en el archivo robots.txt permite a los atacantes acceder a la página. Lo mismo ocurre si intentas ocultar datos privados. - Aunque crear el archivo robots.txt es bastante sencillo, si se equivoca en un solo carácter, echará por tierra todos sus esfuerzos de SEO.

Dónde colocar el archivo Robots.txt

Suponemos que a estas alturas ya sabe dónde hay que añadir el archivo robots.txt.

El archivo robots.txt debe estar siempre en la raíz de su sitio web. Si su dominio es sudominio.com, la URL de su archivo robots.txt será https://yourdomain.com/robots.txt.

Además de incluir su robots.txt en el directorio raíz, aquí tiene algunas prácticas recomendadas que debe seguir,

- Es esencial nombrar su archivo robots.txt

- El nombre distingue entre mayúsculas y minúsculas. Así que hágalo bien, o no funcionará.

- Cada directiva debe ir en una nueva línea

- Incluir un símbolo "$" para marcar el final de una URL

- Utilizar agentes-usuarios individuales una sola vez

- Utilice comentarios para explicar su archivo robots.txt a los humanos comenzando la línea con una almohadilla (#)

Cómo probar su archivo Robots.txt

Ahora que ha creado su archivo robots.txt, es el momento de probarlo utilizando una herramienta de comprobación de robots.txt.

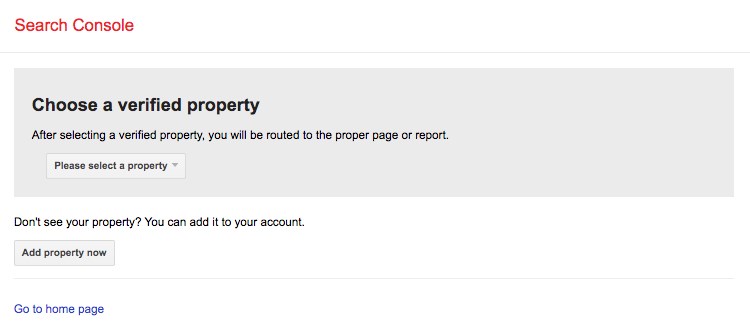

La herramienta que recomendamos es la que se encuentra en el interior Consola de búsqueda de Google.

Para acceder a esta herramienta, pulse Abrir el comprobador de robots.txt.

Suponemos que ha añadido su sitio web a Google Search Console. Si no es así, haga clic en 'Añadir propiedad ahora' y complete los pasos fáciles de seguir para incluir su sitio web en Google Search Console.

Una vez hecho esto, su sitio web aparecerá en el menú desplegable bajo 'Seleccione una propiedad.’

Seleccione el sitio web y la herramienta obtendrá automáticamente el archivo robots.txt de su sitio web y resaltará los errores y advertencias, si los hubiera.

¿Necesita un archivo Robots.txt para su sitio WordPress?

Sí, necesita un archivo robots.txt en su sitio WordPress. Independientemente de que tenga o no un archivo robots.txt, los motores de búsqueda rastrearán e indexarán su sitio web. Pero una vez explicado qué es robots.txt, cómo funciona y el presupuesto de rastreo, ¿por qué no querría incluir uno?

El archivo robots.txt indica a los motores de búsqueda qué deben rastrear y, lo que es más importante, qué no deben rastrear.

Una razón primordial para incluir el robots.txt es considerar los efectos adversos del crawl budget.

Como se ha indicado anteriormente, cada sitio web tiene un crawl budget específico. Esto se reduce al número de páginas que un bot rastrea durante una sesión. Si el bot no completa el rastreo de todas las páginas de su sitio durante la sesión, volverá y reanudará el rastreo en la siguiente sesión.

Y esto ralentiza la tasa de indexación de su sitio web.

Una solución rápida es impedir que los robots de búsqueda rastreen páginas innecesarias, archivos multimedia, plugins, carpetas de temas, etc., con lo que se ahorra cuota de rastreo.

Reflexiones finales

Cuando trabaje en su SEO del sitio webPor eso, damos mucha importancia a la optimización del contenido, la búsqueda de las palabras clave adecuadas y el trabajo con los vínculos de retroceso, generar un sitemap.xmlentre otros factores. Un elemento de SEO al que algunos webmasters prestan menos atención es el archivo robots.txt.

El archivo robots.txt puede no ser de gran importancia cuando se empezando por su sitio web. Pero, a medida que su sitio web crece y aumenta el número de páginas, resulta muy rentable empezar a seguir las mejores prácticas en lo que respecta al archivo robots.txt.

Esperamos que este artículo le haya ayudado a obtener información útil sobre qué es robots.txt y cómo crear uno en su sitio web. Entonces, ¿qué directivas has configurado en tu archivo robots.txt?

Divulgación: Este blog puede contener enlaces de afiliados. Si realiza una compra a través de uno de estos enlaces, es posible que recibamos una pequeña comisión. Leer información. Tenga la seguridad de que sólo recomendamos productos que hemos utilizado personalmente y que creemos que aportarán valor a nuestros lectores. Gracias por su apoyo.

Gracias por este artículo tan detallado. Antes de leer tu guía, no sabía que podíamos crear un robots.txt tan fácilmente. He creado un archivo robots.txt para mi sitio web en cuestión de segundos utilizando Yoast SEO plugin.

Hola Mae,

Me alegro mucho de que te haya resultado útil el artículo 🙂 .

Gracias por compartir este gran recurso. Este artículo fue útil para mí saber robots.txt de una mejor manera. Esta guía nos dio un pedazo de nueva información. He actualizado robots.txt de mi sitio web según sus sugerencias dadas en el artículo. Gracias por mantenernos actualizados con nuevas ideas.

¡Qué bien!

Acabo de terminar de leer el artículo que escribió sobre la opinión de los clientes. Me ha gustado mucho tu claridad en el artículo y la forma en que exploras las cosas. El tema es muy interesante. Siga trabajando así de bien.